| Данный сайт ориентирован на владельцев собственных сайтов либо специалистов, занимающихся SEO - оптимизацией в сети. По данным опроса пользователей интернет 75% из них не опускаются ниже первой страницы, вышедшей в результатах поиска. Поэтому, владельцы сайтов, стараются с помощью различных методов поднять свой проект в результатах поиска, сделать его более совместимым с поисковыми машинами. |

|---|

SEOKLASS - раскручиваем и оптимизируем сайт |

|---|

|

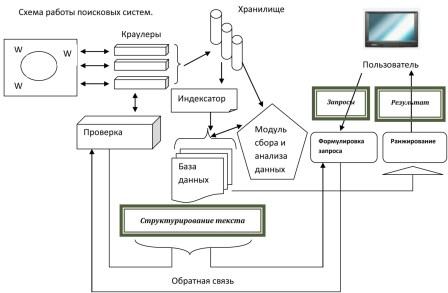

Существует огромное множество статей, книг, различных публикаций на тему работы поисковой машины, описание процесса с момента "ползания" до момента выдачи результатов. Поисковые машины, как правило, стараются обеспечить оптимальную производительность, охват сетевой информации, эффективный поиск, равноправный доступ ко всем ресурсам. Наиболее успешными методами и подходами к информационному поиску, распределению ресурсов по категориям, являются методы, базирующиеся на технологиях статитстической обработки информации. Выделяют 5 наиболее важных компонентов поисковой системы: 1. Модуль Краулера - спайдера. - 2. Модуль склада - база данных. 3. Модуль индексатора - анализа ссылок. 4. Модуль поиска - ранжирования. 5. Интерфейс пользователя. Принцип работы поисковой машины (ПМ).

Любая ПМ имеет уникальную систему, все применяемые методы - являются коммерческой тайной, но, как правило между ними много схожего. Программа спайдера исследует веб - старницы несколькими способами: 1. Находит информацию о сайте на других веб - страницах сети (извлекает ссылки с других сайтов). 2. Исследует страницу из списка URL, полученном при предыдущем исследовании сети (использует первые результаты проведенных поисков). 3. Среди URL, добавляемых вебмастерами вручную, через Add URL. Спайдеры сталкивается со множеством проблем: огромные размеры сети, постоянное изменение данных. Вся информация в сети распределена среди миллионов различных серверов, следовательно, она должна быть собрана и распределена "по складам", прежде чем данные файлы будут доступны для индексации. Качественная поисковая машина имеет фильтры, для отсеивания ненужных страниц. Многие системы поиска сами подстраиваются под сайты: определяют частоту сканирования исходя из определенных факторов: рейтинга, частоты обновления информации и др. |